Em algum momento da infância quase todo mundo escuta a mesma pergunta: o que você vai ser quando crescer? A resposta quase sempre vem no singular. Médico. Engenheiro. Advogado. Como se fosse preciso escolher uma única especialidade cedo demais e carregá-la pelo resto da vida.

Durante muito tempo, essa lógica fez bastante sentido. O mundo recompensava profundidade. Quanto mais alguém se aprofundava em um único campo, mais valioso se tornava. Décadas de estudo, anos de experiência, várias especializações. Era assim que se construía autoridade.

A inteligência artificial não acabou com essa lógica, mas certamente bagunçou parte dela.

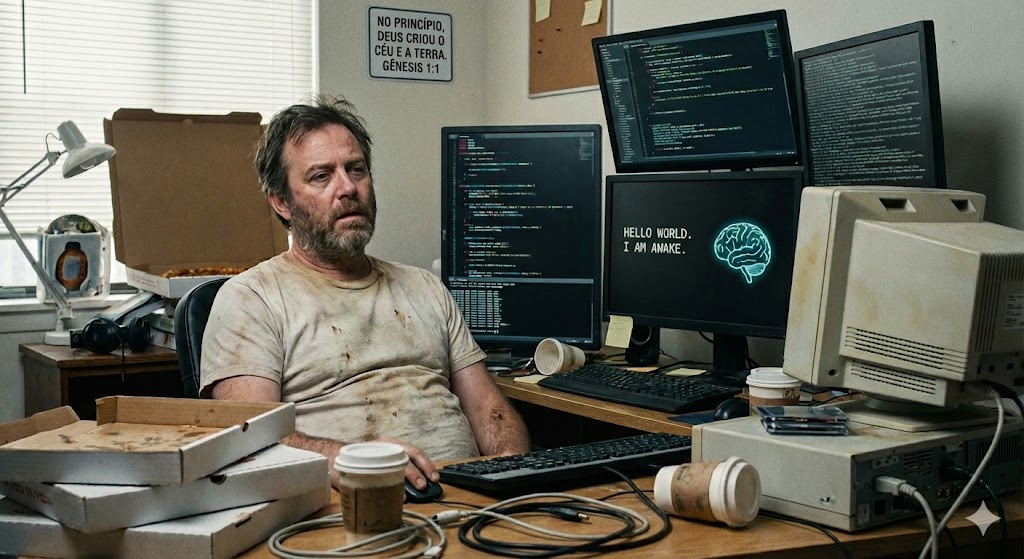

Hoje qualquer pessoa pode fazer uma pergunta extremamente específica sobre praticamente qualquer assunto e obter uma resposta em segundos. Aquilo que antes exigia horas de pesquisa, consulta a livros ou especialistas, agora cabe em uma caixa de texto. Competir com a máquina nesse terreno começa a parecer algo sem sentido. É um pouco como tentar fazer contas de cabeça mais rápido que uma calculadora.

Isso não significa que a especialização perdeu valor. Pelo contrário. Alguém ainda precisa produzir conhecimento novo, validar ideias e, em muitos casos, treinar os próprios sistemas de inteligência artificial. Enquanto a máquina ainda depende de nós para aprender coisas novas, especialistas continuam sendo essenciais.

O problema talvez esteja em outro lugar.

Durante décadas formamos uma enorme quantidade de semi-especialistas, aqueles com conhecimento razoável em um campo estreito, mas não profundo o suficiente para expandir esse campo. Esse tipo de conhecimento intermediário era extremamente útil em um mundo onde informação era escassa. Hoje ele compete diretamente com máquinas que conseguem acessar e organizar quantidades gigantescas de conhecimento em segundos.

Nesse cenário, dois perfis parecem ganhar importância ao mesmo tempo. De um lado, os especialistas muito profundos, que continuam empurrando as fronteiras do conhecimento e criando as bases que a própria inteligência artificial utiliza. Do outro, os generalistas curiosos, que conseguem circular entre áreas diferentes e usar essas ferramentas com algum senso de direção.

A qualidade das respostas de uma inteligência artificial depende bastante da qualidade das perguntas, e boas perguntas raramente nascem de quem conhece apenas uma coisa. Quem já passou por tecnologia, negócios, comportamento humano ou história tende a reconhecer padrões que especialistas às vezes demoram mais para perceber. Não porque saibam mais profundamente sobre um único assunto, mas porque conseguem combinar ideias, e também desenvolver um certo senso crítico para distinguir entre algo que apenas soa convincente e aquilo que realmente faz sentido.

Marc Andreessen, uma das vozes influentes do Vale do Silício, comentou algo nessa linha ao falar sobre o perfil de profissionais na era da IA. Entre apostar em especialistas ou generalistas, ele disse que ficaria com os generalistas. A lógica é simples: a inteligência artificial funciona como um amplificador de profundidade sob demanda. Ela permite mergulhar em qualquer assunto quando necessário. Mas alguém ainda precisa decidir em que direção mergulhar.

Talvez por isso a velha curiosidade generalista esteja ganhando uma utilidade inesperada. Ler sobre assuntos diferentes, experimentar áreas distintas, cultivar interesses que aparentemente não têm relação entre si. Durante muito tempo isso parecia falta de foco. Hoje pode ser exatamente o contrário.

A inteligência artificial aprofunda, mas nós, pelo menos por enquanto, ainda conectamos as coisas.